A large language model (LLM) is a deep learning algorithm pre-trained on massive amounts of data. LLMs use transformer models — a set of neural networks that includes an encoder and decoder with self-attention capabilities. Essentially, the encoder and decoder identify meanings from text and understand the relationships between the words and phrases in it.

This article provides an overview of LLMs, including how they work, their applications, and future innovations. It also highlights the advantages of implementing LLMs for your business and how to use them for success.

Large Language Models Explained

Large language models are foundational models that use natural language processing and machine learning models to generate text. Natural language processing is a branch of artificial intelligence (AI) concerned with giving computers the ability to understand text and spoken words in much the same way human beings can.

By combining computational linguistics with statistical machine learning and deep learning models, LLMs can process human language in the form of voice data or text to understand its whole meaning, including user intent and sentiment.

There are different types of large language models, such as:

- Generic or raw language models: Trained to predict the next word based on the language in the training data, typically used to perform information retrieval tasks.

- Instruction-tuned language models: Trained to predict responses to the instructions given in the input, allowing them to perform sentiment analysis or generate code or text.

- Dialog-tuned language models: Trained to have a dialogue by predicting future responses. Examples include chatbots and virtual assistants.

The goal of LLMs is to predict the text likely to come next. LLMs are pre-trained on vast amounts of data to understand the complexities and linkages of language. The sophistication and performance of an LLM can be judged by the number of parameters it has — or the factors it considers when generating output.

Generative AI vs. Large Language Models

Generative AI is an umbrella term that refers to AI models capable of generating content. LLMs are a specific category of generative AI models with a specialized focus on text-based data. Essentially, all large language models are generative AI. The main differences between generative AI vs. LLMs include:

- Training: Generative AI undergoes extensive training on large datasets to connect patterns and relationships present within that data. Once trained, they can generate new content that aligns with the characteristics of the training data. In contrast, LLMs are trained on vast volumes of text data, from books and articles to code. After training, LLMs can complete text-related tasks.

- Scope: While generative AI uses many models to create new content beyond textual data, LLMs excel at understanding language patterns to predict and generate text accurately.

- Type of content: As mentioned, generative AI creates images, music code, and other content beyond text. They are a good fit for creative fields like music, art, and content creation. LLMs are best suited for text-based tasks and applications like chatbots, language translation, and content summarization.

When used together, generative AI and LLMs can enhance various applications like content personalization, storytelling, and content generation. For example, a generative AI model trained on artwork datasets could be improved by LLMs trained on art history by generating descriptions and analyses of artwork. A business could use that combination to create marketing images and phrasing that improves user intent, ultimately helping boost sales.

How Do Large Language Models Work?

A transformer model is the most common basis for a large language model, consisting of an encoder and a decoder. The transformer model processes data by tokenizing the input and conducting mathematical equations to discover the relationships between the tokens, or words. This process allows the computer to see patterns a human would if given the same query.

Before working from a transformer model, LLMs must undergo training to ensure they can fulfill general functions, and fine-tune their skills to perform specific tasks. Large language models are often trained on massive textual datasets like Wikipedia, containing trillions of words.

During training, the LLM engages in unsupervised learning, which is processing datasets given to it without specific instructions. This stage allows the LLM’s AI algorithm to decipher the meaning of words and the relationships between words. It also learns to distinguish words based on context. For example, it would learn whether “right” means “correct” or the opposite of “left.”

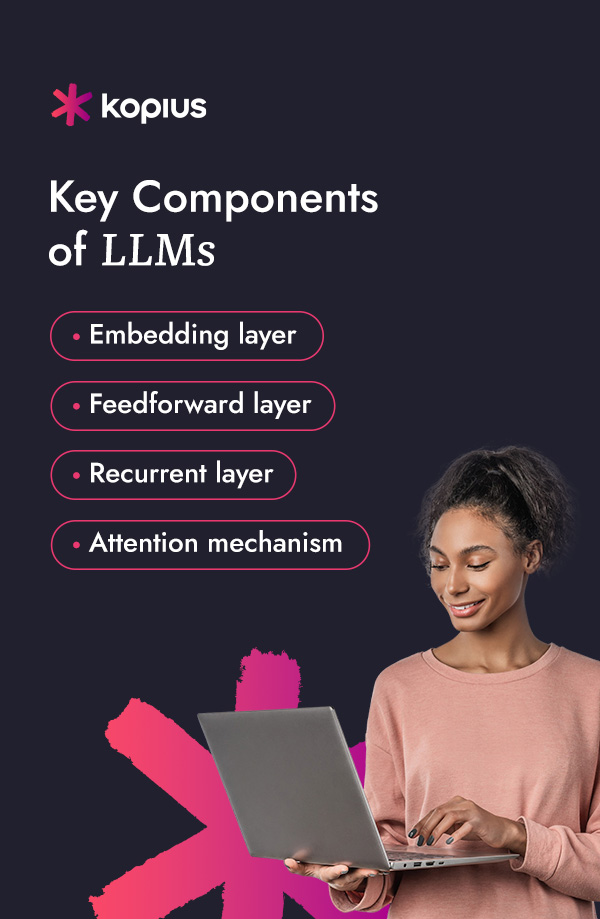

Key Components of LLMs

Large language models consist of several neural network layers — recurrent, embedding, attention, and feedforward layers — that work together to process input text and generate output content. Here’s how these components work:

- Embedding layer: The embedding layer consists of vectors representing words in a way the machine learning model can quickly process. This part of the large language model is working on dissecting the meaning and context of the input.

- Feedforward layer: The feedforward layer consists of various connected layers that transform the input embeddings. This allows the model to glean higher-level abstractions or understand the user’s intent with the text input.

- Recurrent layer: The recurrent layer analyzes each word in a sequence provided in the input, capturing the relationship between words in a sentence.

- Attention mechanism: The attention mechanism enables the language model to focus on single parts of the input text that are relevant to the task at hand. This layer allows the model to generate the most accurate outputs.

Business Applications of Large Language Models

Large language models have numerous applications in business environments. Key examples include:

1. Content Creation

LLMs can help generate valuable content spanning many formats, from articles and blog posts to product descriptions and social media posts — saving your company plenty of time and resources. As writing assistants, large language models can also provide real-time grammar, spelling, and phrasing suggestions.

Further, language models can help your company generate fresh outlines by analyzing existing content and trending topics, helping you develop relevant content that resonates with your target group.

2. Search Engine Optimization

Large language models can also help you optimize your content for search engines by:

- Suggesting relevant keywords to enhance visibility in search results

- Identifying common search queries to tailor your content to match user intent

- Helping structure content to improve ranking in search results

- Conducting SEO audits to analyze your website’s speed and areas for improvements

Using LLMs’ recommendations about SEO strategy can help improve user engagement and improve your site’s visibility.

3. Customer Service

Large language models can help improve the customer service experience by automating various interactions. For instance, chatbots can respond to customer inquiries, help with troubleshooting, and provide relevant information 24/7. Additionally, virtual sales assistants can engage with customers, answer product questions, and guide them through the sales process.

4. Virtual Collaboration

You can also use LLMs to enhance staff productivity and effectiveness. The AI tool can help facilitate collaboration and streamline routine tasks. Examples of functions LLMs can perform include:

- Generate meeting summaries and transcriptions

- Provide real-time translations for multilingual teams

- Facilitate knowledge sharing

- Document company and project-related processes

- Assist team members with disabilities, such as vision or hearing impairment

5. Sales

Large language models can also support sales professionals with various processes, including:

- Lead identification: LLMs can identify potential leads by analyzing massive amounts of data to understand customer preferences. This can help your sales teams target high-quality leads with a higher likelihood of conversion.

- AI-powered chatbots: AI chatbots can engage with website visitors, collect information, and provide teams with customer insights to generate more leads.

- Personalized sales outreach: Using customer information and data, LLMs can help craft personalized sales outreach messages, such as customized emails and product recommendations.

- Customer feedback analysis: AI strategies can also analyze customer feedback and pain points to help sales teams personalize their approach and build stronger relationships.

6. Fraud Detection

Large language models also offer fraud detection capabilities. They can analyze textual data, identify patterns, and detect issues to help your company fight against fraud. These AI strategies provide real-time monitoring, such as financial transactions or customer interaction. They can quickly identify suspicious patterns and generate real-time alerts to jumpstart an investigation.

Applications and Use Cases in Other Industries

With various applications, you can find uses for LLMs in several fields, such as:

- Marketing and advertising: LLMs excel in generating high-quality content, making them a good fit for personalized marketing, chatbots, content creation, ad targeting, and measuring the effectiveness of marketing campaigns.

- Retail and e-commerce: Large language models can analyze customer data to generate personalized recommendations for products and services. They can also help answer customer inquiries, assist in purchases, and detect fraud.

- Health care: Large language models are being used in health care to improve medical diagnoses, patient monitoring, drug discovery, and virtual reality training. LLMs are revolutionizing the health care industry to improve patient satisfaction and health outcomes.

- Science: LLMs can understand proteins, molecules, and DNA. They can potentially be used in the development of vaccines, finding cures, and improving preventative care medicines.

- Tech: Large language models are widely used in the tech industry, from allowing search engines to respond to queries to assisting developers with writing code.

- Finance: LLMs are used in finance to improve the efficiency, accuracy, and transparency of financial markets. They can complete risk assessment tasks, assist in trading and fraud detection, and help financial institutions comply with regulations.

- Legal: These AI strategies have helped lawyers, paralegals, and legal staff search massive textual datasets and generate legal phrasing. LLMs can streamline tasks like research and document drafting to save time.

Benefits of Large Language Models

The benefits of rolling out large language models for your business include:

Deeper Levels of Comprehension

Unlike earlier chatbots and automated systems that relied on keyword matching and rigid scripts, LLMs can better understand the context, sentiment, and intent behind queries. This allows better customer-support chatbots, virtual assistants, and search engines. For example, in e-commerce, when an online shopper has a question for the online assistant, AI can dissect the question and reveal its context to provide a relevant and accurate response.

Saved Time

Large language models can produce almost anything text-related, from quick suggestions to lengthy essays. As a result, marketers, journalists, and even employees who aren’t tasked with writing are using LLMs to streamline their work and create professional content. This saved time and effort can be channeled into personalizing the content.

Enhanced Efficiency and Accuracy

Traditional methods of text processing and analysis methods can be daunting and prone to errors, especially when working with vast datasets. By contrast, with their deep-learning algorithms, LLMs can analyze data at unparalleled speeds, reducing or eliminating manual work altogether. For example, businesses can use LLMs to scour customer reviews, identify common issues and areas they’re doing well, and respond to customers quickly — saving a lot of time in the process.

Personalized Experiences

By collecting data and analyzing customer behavior and preferences, LLMs offer personally tailored recommendations and experiences. For instance, LLMs can work as product recommendation engines that suggest items to shoppers based on browsing and purchasing history. This increases the likelihood of conversions and a better customer experience.

Considerations When Implementing LLMs

While LLMs provide many advantages across business applications, they also come with a few considerations to note. This technology is still growing and changing, meaning companies will need to be aware of risks like:

- Hallucinations or falsehoods generated as a result of poorly trained LLMs

- Biases when the datasets aren’t diverse enough

- Security issues, such as cybercriminals using the LLM for phishing and spamming

- Challenges in scaling and maintaining LLMs

Using LLMs for Business Success

LLMs will continue developing and learning, offering various innovations for businesses. With improvements like better accuracy, audiovisual training, and enhanced performance of automated virtual assistants, you’ll want to get ahead of the competition and use AI to transform your workplace. While it can be challenging to implement LLMs without technical expertise, the right consultants can guide your LLM strategy, ensuring it drives success for your company.

By considering your unique objectives and resources, the experts at Kopius can help you implement AI and machine learning (ML) solutions to empower your team and strengthen your company for the long term.

Our focus areas include:

- Customer service automation

- Data analytics and business intelligence

- Process automation and optimization

- AI and ML strategy development

- Bias mitigation and fairness

- Personalization and marketing automation

- Churn prevention and customer retention

- Supply chain optimization

- Talent acquisition

At Kopius, our AI and ML solutions can transform inefficiencies in your company and improve your decision-making. When working with us, our experts will highlight the areas of your business that could grow the most with artificial intelligence and machine learning.

Explore LLM Opportunities With Kopius

LLMs can unlock exciting possibilities for your business, including streamlining tedious administrative tasks, generating fresh content, enhancing your marketing efforts, and personalizing the customer experience. When you’re ready to implement AI and machine learning for your business, Kopius is here to help with digital technology consulting services.

While it can be challenging to implement these strategies on your own, our consultants have the knowledge and expertise to help you get the most out of technology and drive real results. We consider your unique needs and goals to develop a plan that works best for you. To get started, contact us today.

Related Services:

- Artificial Intelligence & Machine Learning

- Generative AI

- Natural Language Processing

- Data & AI Ideation Workshops